known KNOWS, unknows UNKNOWS

- und was es sonst noch so gibt ???

-

Aus Sicht von ENS ergeben sich verschiedene, generelle organisatorische Handlungsoptionen und –Möglichkeiten.

|

●

|

Zuerst muss eine Organisation ständig damit rechnen, dass Fehler passieren.

Sie muss also auf Fehler eingestellt sein (Murphy’s Law: Was schief gehen kann, das wird auch schief gehen!). |

|

●

|

Organisationen sollten deshalb für einen offenen Umgang mit Informationen und Fehlern sorgen (Offene Fehlerkultur) (siehe z.B. „Lernende Organisationen (LeOs)“ ).

|

|

●

|

Organisationen sollten mit Fehlern so umgehen, dass diese frühzeitig erkannt und nicht zu größeren Problemen (z.B. schweren Unfällen) führen (siehe z.B. High Reliability Organisationen (HROs).

|

|

●

|

Organisationen sollten sich aber dennoch darauf vorbereiten, dass Fehler auch zu schwereren Folgen führen können, und, dass sie damit umgehen können müssen (siehe z.B. „Resiliente Organisation“ )

|

Die Stichworte (offene Fehlerkultur, LeO, HRO, Resilienz, usw.) stehen hier als Synonyme für entsprechende Beschreibungen in der Literatur und entsprechende operative Umsetzungen in Unternehmen (natürlich können und werden auch andere Begriffe oder Namen mit gleichen oder ähnlichen Inhalten verwendet, siehe z.B. Holistische Managementsysteme (HMS)). Letztendlich geht es bei der konkreten Realisierung solcher Modelle in Unternehmen um konkrete organisatorische Maßnahmen, die auf der Website von ENS unter den Stichworten Managementsysteme, holistische Managementsysteme, Lernende Organisation (LeO) oder High Reliability Organisationen (HROs) usw. exemplarisch beschrieben werden sollen.

Aus Wikipedea /1/:

Der Ingenieur Captain Edward A. Murphy nahm 1949 am Raketenschlittenprogramm der US Air Force auf einem kalifornischen Testgelände teil, mit dem herausgefunden werden sollte, welche Beschleunigungen der menschliche Körper aushalten kann.

Bei einem sehr kostspieligen Experiment wurden am Körper der Testperson 16 Messsensoren befestigt. Diese Sensoren konnten auf zwei Arten befestigt werden: auf die richtige und in 90° Abweichung von dieser. Das Experiment schlug fehl, weil jemand sämtliche Sensoren falsch angeschlossen hatte. Diese Erfahrung veranlasste Murphy, sein Gesetz zu formulieren.

Die Urfassung lautete:

„If there’s more than one possible outcome of a job or task, and one of those outcomes will result in disaster or an undesirable consequence, then somebody will do it that way.“

Aus Sicht von ENS bedeutet dies:

Fehler können nicht mit 100% iger Sicherheit vermieden werden, und wir sollten vielleicht auch nicht versuchen, dies zu erreichen.

Wenn Fehler aber früher oder später mit großer Sicherheit doch passieren, dann müssen wir uns darauf einstellen, indem wir

|

1.

|

mögliche Fehler möglichst frühzeitig erkennen,

|

|

2.

|

bei möglichen Lösungen auch mögliche Alternativen berücksichtigen, wobei

|

|

a.

|

Lösungen hier bedeuten kann, Fehler verhindern, oder Auswirkungen vermeiden oder vermindern.

|

|

2.

|

möglichst schnell wieder den „Normalbetrieb“ erreichen, und

|

|

3.

|

Fehler auswerten und Verbesserungen einleiten.

|

Warum sind Fehler letztendlich nicht vermeidbar?

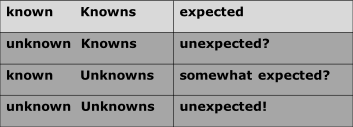

Verschiedenen Quellen wird folgende „Beschreibung des Wissens“ und Nicht-Wissens zugeschrieben:

Dabei bedeuten die 4 Stufen des Wissens und Nicht-Wissens aus Sicht von ENS :

|

1.

|

was wir wissen, gelernt haben und umsetzen

(hier sind wir vorbereitet - |

|

2.

|

was wir eigentlich wissen, aber vergessen oder nicht beachtet haben

(hier sind wir nicht vorbereitet - |

|

3.

|

was wir vermuten, das wir es nicht wissen

(hier können wir uns nur unspezifisch vorbereiten - |

|

4.

|

was wir nicht wissen und wo wir auch nicht vermuten, dass wir etwas nicht wissen (hier können wir uns nicht vorbereiten -

|

Deshalb ist aus Sicht von ENS eine spezielle Einstellung und Vorbereitung von Menschen und Organisationen auf das Auftreten von Fehlern notwendig. Es muss versucht werden, das Undenkbare zu denken.

Es ist aus Sicht von ENS eine entwickelte Sicherheitskultur notwendig, die mögllichst auf alle Arten von Fehlern und „mishaps“ vorbereitet ist.

Stichworte hier sind die bereits oben erwähnten: Managementsysteme, holistische Managementsysteme, Lernende Organisation (LeO) oder High Reliability Organisationen (HROs), usw. .

JH 12.11.2016

Literaturhinweise (nur Beispiele)

|

1.

|